Inspirándose en nociones de la física y la biología, Hopfield y Hinton desarrollaron sistemas informáticos capaces de memorizar y aprender de patrones en los datos. Aunque nunca colaboraron directamente, se basaron en el trabajo del otro para desarrollar las bases del actual auge del aprendizaje automático y la inteligencia artificial (IA).

¿Qué son las redes neuronales?

Las redes neuronales artificiales están detrás de gran parte de la tecnología de IA que utilizamos hoy en día.

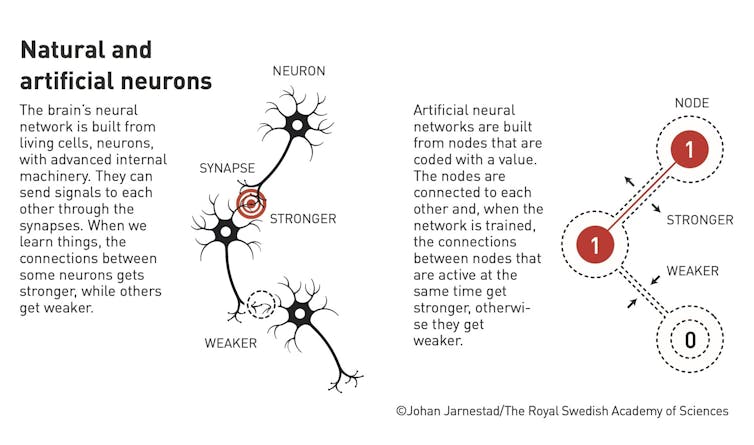

De la misma manera que nuestro cerebro tiene células neuronales unidas por sinapsis, las redes neuronales artificiales tienen neuronas digitales conectadas en varias configuraciones. Cada neurona individual no hace gran cosa. La magia reside en el patrón y la fuerza de las conexiones entre ellas.

Las neuronas de una red neuronal artificial se “activan” mediante señales de entrada. Estas activaciones se transmiten en cascada de una neurona a otra de forma que pueden transformar y procesar la información de entrada. Como resultado, la red puede llevar a cabo tareas computacionales como la clasificación, la predicción y la toma de decisiones.

La mayor parte de la historia del aprendizaje automático ha consistido en encontrar formas cada vez más sofisticadas de formar y actualizar estas conexiones entre neuronas artificiales.

Mientras que la idea de enlazar sistemas de nodos para almacenar y procesar información procede de la biología, las matemáticas utilizadas para formar y actualizar estos enlaces proceden de la física.

Redes que recuerdan

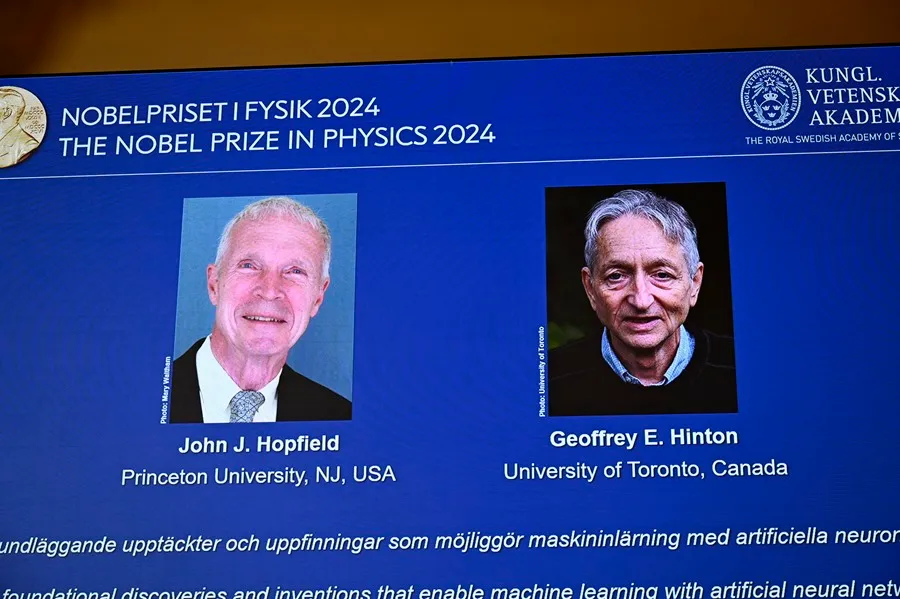

John Hopfield (nacido en 1933) es un físico teórico estadounidense que realizó importantes contribuciones a lo largo de su carrera en el campo de la física biológica. Sin embargo, el premio Nobel de Física le ha sido concedido por su trabajo en el desarrollo de las redes de Hopfield en 1982.

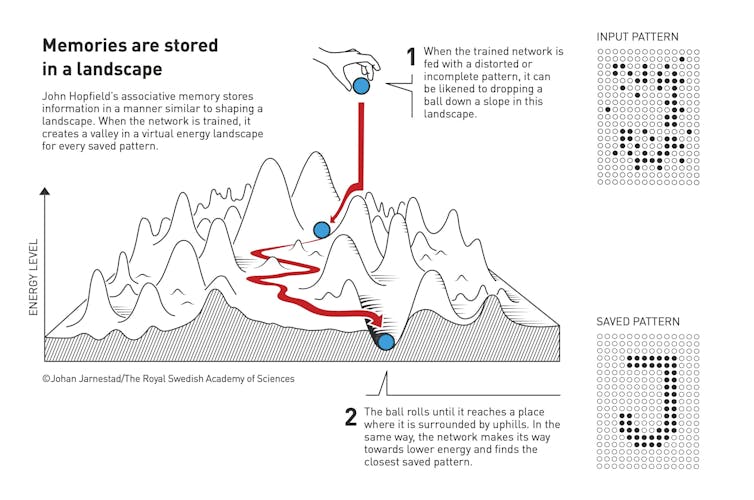

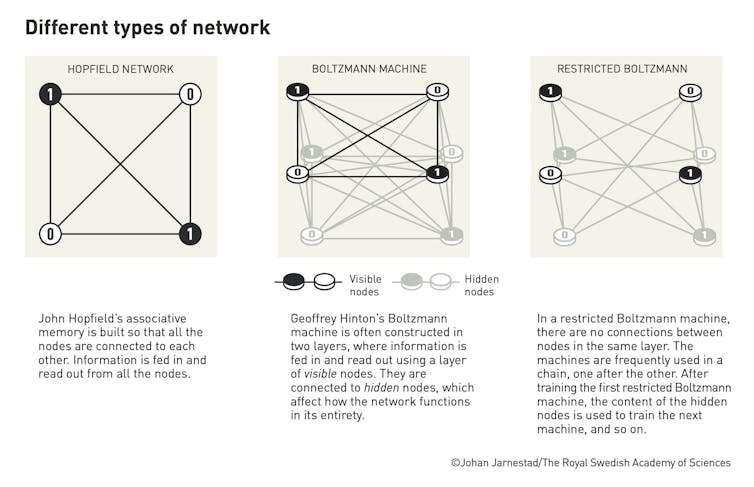

Las redes de Hopfield fueron uno de los primeros tipos de redes neuronales artificiales. Inspirados en principios de la neurobiología y la física molecular, estos sistemas demostraron por primera vez cómo un ordenador podía utilizar una “red” de nodos para recordar y recuperar información.

Las redes desarrolladas por Hopfield podían memorizar datos (como una colección de imágenes en blanco y negro). Estas imágenes podían “recordarse” por asociación cuando se le pedía a la red una imagen similar.

Aunque de uso práctico limitado, las redes de Hopfield demostraron que este tipo de redes neuronales artificiales podían almacenar y recuperar datos de formas novedosas. Sentaron las bases para los trabajos posteriores de Hinton.

Máquinas que pueden aprender

Geoff Hinton (nacido en 1947), a veces considerado uno de los padrinos de la IA, es un informático británico-canadiense que ha realizado una serie de importantes contribuciones a este campo. En 2018, junto con Yoshua Bengio y Yann LeCun, fue galardonado con el Premio Turing (el más alto honor en ciencias de la computación) por sus esfuerzos para avanzar en el aprendizaje automático en general y, específicamente, en una rama del mismo llamada aprendizaje profundo.

El Premio Nobel de Física, sin embargo, se le concede concretamente por su trabajo con Terrence Sejnowski y otros colegas en 1984, desarrollando máquinas de Boltzmann.

Se trata de una extensión de la red de Hopfield que demostró la idea del aprendizaje automático: un sistema que permite a un ordenador aprender no de un programador, sino de ejemplos de datos. Basándose en ideas de la dinámica energética de la física estadística, Hinton demostró cómo este primer modelo de ordenador generativo podía aprender a almacenar datos a lo largo del tiempo si se le mostraban ejemplos de cosas que recordar.

La máquina de Boltzmann, al igual que la red de Hopfield, no tuvo aplicaciones prácticas inmediatas. Sin embargo, una forma modificada (llamada máquina de Boltzmann restringida) resultó útil en algunos problemas aplicados.

Más importante fue el avance conceptual de que una red neuronal artificial podía aprender de los datos. Hinton siguió desarrollando esta idea. Más tarde publicó influyentes artículos sobre retropropagación (el proceso de aprendizaje utilizado en los modernos sistemas de aprendizaje automático) y redes neuronales convolucionales (el principal tipo de red neuronal utilizado hoy en día para los sistemas de IA que trabajan con datos de imagen y vídeo).

¿Por qué este premio, ahora?

Las redes de Hopfield y las máquinas de Boltzmann parecen poca cosa si las comparamos con las proezas actuales de la IA. La red de Hopfield contenía sólo 30 neuronas (intentó hacer una con 100 nodos, pero era demasiado para los recursos informáticos de la época), mientras que sistemas modernos como ChatGPT pueden tener millones. Sin embargo, el Nobel subraya lo importantes que fueron estas primeras contribuciones al campo.

Aunque el rápido progreso reciente de la IA –que la mayoría conocemos por sistemas de IA generativa como ChatGPT– podría parecer una reivindicación de los primeros defensores de las redes neuronales, Hinton al menos ha expresado su preocupación. En 2023, tras abandonar su puesto de una década en la división de IA de Google, dijo que estaba asustado por el ritmo de desarrollo y se unió a la creciente multitud de voces que piden una regulación más proactiva de la IA.

Tras recibir el premio Nobel, Hinton aseguró que la IA será “como la Revolución Industrial, pero en lugar de nuestras capacidades físicas, va a superar nuestras capacidades intelectuales”. También señaló que aún le preocupa que las consecuencias de su trabajo puedan ser “sistemas más inteligentes que nosotros que acaben tomando el control”.

Este artículo fue publicado originalmente en The Conversation.